| 全文检索引擎Solr系列——Solr核心概念、配置文件

Document

Document是Solr索引(动词,indexing)和搜索的最基本单元,它类似于关系数据库表中的一条记录,可以包含一个或多个字段(Field),每个字段包含一个name和文本值。字段在被索引的同时可以存储在索引中,搜索时就能返回该字段的值,通常文档都应该包含一个能唯一表示该文档的id字段。例如:

<doc>

<field name="id">company123</field>

<field name="companycity">Atlanta</field>

<field name="companystate">Georgia</field>

<field name="companyname">Code Monkeys R Us, LLC</field>

<field name="companydescription">we write lots of code</field>

<field name="lastmodified">2013-06-01T15:26:37Z</field>

</doc> |

Schema

Solr中的Schema类似于关系数据库中的表结构,它以schema.xml的文本形式存在在conf目录下,在添加文当到索引中时需要指定Schema,Schema文件主要包含三部分:字段(Field)、字段类型(FieldType)、唯一键(uniqueKey)

字段类型(FieldType):用来定义添加到索引中的xml文件字段(Field)中的类型,如:int,String,date,

字段(Field):添加到索引文件中时的字段名称

唯一键(uniqueKey):uniqueKey是用来标识文档唯一性的一个字段(Feild),在更新和删除时用到

例如:

<schema name="example" version="1.5">

<field name="id" type="string" indexed="true" stored="true" required="true" multiValued="false" />

<field name="title" type="text_general" indexed="true" stored="true" multiValued="true"/>

<uniqueKey>id</uniqueKey>

<fieldType name="string" class="solr.StrField" sortMissingLast="true" />

<fieldType name="text_general" class="solr.TextField" positionIncrementGap="100">

<analyzer type="index">

<tokenizer class="solr.StandardTokenizerFactory"/>

<filter class="solr.StopFilterFactory" ignoreCase="true" words="stopwords.txt" />

<!-- in this example, we will only use synonyms at query time

<filter class="solr.SynonymFilterFactory" synonyms="index_synonyms.txt" ignoreCase="true" expand="false"/>

-->

<filter class="solr.LowerCaseFilterFactory"/>

</analyzer>

<analyzer type="query">

<tokenizer class="solr.StandardTokenizerFactory"/>

<filter class="solr.StopFilterFactory" ignoreCase="true" words="stopwords.txt" />

<filter class="solr.SynonymFilterFactory" synonyms="synonyms.txt" ignoreCase="true" expand="true"/>

<filter class="solr.LowerCaseFilterFactory"/>

</analyzer>

</fieldType>

</schema> |

Field

在Solr中,字段(Field)是构成Document的基本单元。对应于数据库表中的某一列。字段是包括了名称,类型以及对字段对应的值如何处理的一种元数据。比如:

<field name="name" type="text_general"

indexed="true" stored="true"/>

Indexed:Indexed=true时,表示字段会加被Sorl处理加入到索引中,只有被索引的字段才能被搜索到。

Stored:Stored=true,字段值会以保存一份原始内容在在索引中,可以被搜索组件组件返回,考虑到性能问题,对于长文本就不适合存储在索引中。

Field Type

Solr中每个字段都有一个对应的字段类型,比如:float、long、double、date、text,Solr提供了丰富字段类型,同时,我们还可以自定义适合自己的数据类型,例如:

<!-- Ik 分词器 -->

<fieldType name="text_cn_stopword" class="solr.TextField">

<analyzer type="index">

<tokenizer class="org.wltea.analyzer.lucene.IKAnalyzerSolrFactory" useSmart="false"/>

</analyzer>

<analyzer type="query">

<tokenizer class="org.wltea.analyzer.lucene.IKAnalyzerSolrFactory" useSmart="true"/>

</analyzer>

</fieldType>

<!-- Ik 分词器 --> |

Solrconfig:

如果把Schema定义为Solr的Model的话,那么Solrconfig就是Solr的Configuration,它定义Solr如果处理索引、高亮、搜索等很多请求,同时还指定了缓存策略,用的比较多的元素包括:

指定索引数据路径

<!--

Used to specify an alternate directory to hold all index data

other than the default ./data under the Solr home.

If replication is in use, this should match the replication configuration.

-->

<dataDir>${solr.data.dir:./solr/data}</dataDir> |

缓存参数

<filterCache

class="solr.FastLRUCache"

size="512"

initialSize="512"

autowarmCount="0"/>

<!-- queryResultCache caches results of searches - ordered lists of

document ids (DocList) based on a query, a sort, and the range

of documents requested. -->

<queryResultCache

class="solr.LRUCache"

size="512"

initialSize="512"

autowarmCount="0"/>

<!-- documentCache caches Lucene Document objects (the stored fields for each document).

Since Lucene internal document ids are transient, this cache will not be autowarmed. -->

<documentCache

class="solr.LRUCache"

size="512"

initialSize="512"

autowarmCount="0"/> |

请求处理器

请求处理器用于接收HTTP请求,处理搜索后,返回响应结果的处理器。比如:query请求:

<!-- A request handler that returns indented JSON by default -->

<requestHandler name="/query" class="solr.SearchHandler">

<lst name="defaults">

<str name="echoParams">explicit</str>

<str name="wt">json</str>

<str name="indent">true</str>

<str name="df">text</str>

</lst>

</requestHandler> |

每个请求处理器包括一系列可配置的搜索参数,例如:wt,indent,df等等。

全文检索引擎Solr系列——整合中文分词组件mmseg4j

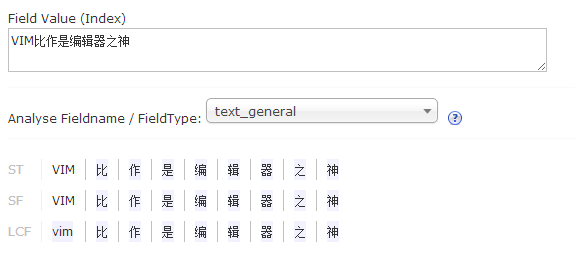

默认Solr提供的分词组件对中文的支持是不友好的,比如:“VIM比作是编辑器之神”这个句子在索引的的时候,选择FieldType为”text_general”作为分词依据时,分词效果是:

它把每一个词都分开了,可以想象如果一篇文章这样分词的搜索的体验效果非常差。能够和Solr集成的中文分词组件有很多,比如:mmseg4j、IkAnalyzer、ICTCLAS等等。各有各的特点。这篇文章讲述如何整合Solr与mmseg4j。mmeseg4j最新版本是1.9.1,下载解压,提取其中的三个文件:mmseg4j-analysis-1.9.1.jar,

mmseg4j-core-1.9.1.jar,mmseg4j-solr-1.9.1.jar。放到目录:E:\solr-4.8.0\example\solr-webapp\webapp\WEB-INF\lib,修改配置文件schema.xml,添加下面的两段代码:

fieldType:

<!-- mmseg4j-->

<fieldType name="text_mmseg4j_complex" class="solr.TextField" positionIncrementGap="100" >

<analyzer>

<tokenizer class="com.chenlb.mmseg4j.solr.MMSegTokenizerFactory" mode="complex" dicPath="dic"/>

</analyzer>

</fieldType>

<fieldType name="text_mmseg4j_maxword" class="solr.TextField" positionIncrementGap="100" >

<analyzer>

<tokenizer class="com.chenlb.mmseg4j.solr.MMSegTokenizerFactory" mode="max-word" dicPath="dic"/>

</analyzer>

</fieldType>

<fieldType name="text_mmseg4j_simple" class="solr.TextField" positionIncrementGap="100" >

<analyzer>

<!--

<tokenizer class="com.chenlb.mmseg4j.solr.MMSegTokenizerFactory"

mode="simple" dicPath="n:/OpenSource/apache-solr-1.3.0/example/solr/my_dic"/>

-->

<tokenizer class="com.chenlb.mmseg4j.solr.MMSegTokenizerFactory" mode="simple" dicPath="dic"/>

</analyzer>

</fieldType>

<!-- mmseg4j--> |

与fieldType对应的field:

<!-- mmseg4j -->

<field name="mmseg4j_complex_name" type="text_mmseg4j_complex" indexed="true" stored="true"/>

<field name="mmseg4j_maxword_name" type="text_mmseg4j_maxword" indexed="true" stored="true"/>

<field name="mmseg4j_simple_name" type="text_mmseg4j_simple" indexed="true" stored="true"/>

<!--mmseg4j --> |

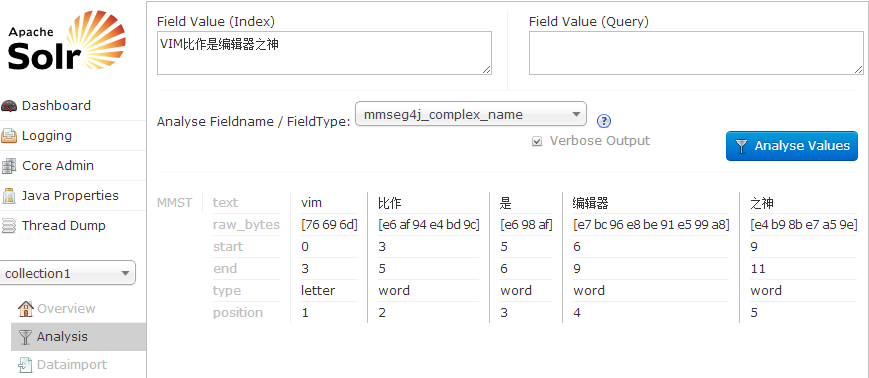

此时就算配置完成了,重启服务:java -jar start.jar,来看看mmseg4j的分词效果怎么样,打开Solr管理界面,点击左侧的Analysis页面

对比之前的分词效果,改进了很多,差不多就是正常的语义了。这里在分词的时候你有可能会遇到一个问题:

TokenStream contract violation: reset()/close() call

missing, reset() called multiple times, or subclass

does not call super.reset(). Please see Javadocs of

TokenStream class for more information about the correct

consuming workflow.

这个是Solr4.8环境下mmseg4j的一个bug,这是mmseg4j-analysis-1.9.1.jar引起的,需要修改源码,找到文件:mmseg4j-1.9.1\mmseg4j-analysis\src\main\java\com\chenlb\mmseg4j\analysis\MMSegTokenizer.java,加上super.reset():

public void reset() throws IOException {

//lucene 4.0

//org.apache.lucene.analysis.Tokenizer.setReader(Reader)

//setReader 自动被调用, input 自动被设置。

super.reset(); //加上这一行

mmSeg.reset(input);

} |

修改完之后用maven重启编译:mvn clean package -DskipTests,用新的mmseg4j-1.9.1\mmseg4j-analysis\target\mmseg4j-analysis-1.9.2-SNAPSHOT.jar替换掉原来那个文件,重启服务就ok了。

mmeseg4j-1.9.1这个版本的的词库全部打包放在了jar文件里面,因此无需再指定词库文件(chars.dic,units.dic,words.dic),当然你也可以覆盖这些文件,只需要吧预替换的文件放在在WEB-INF\data\即可。

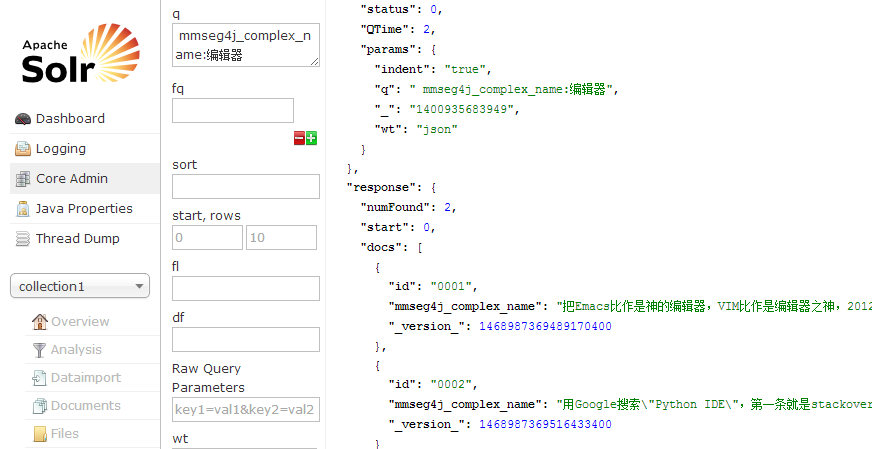

现在添加两个中文文档到索引中去,试试mmeseg4j的效果怎么样:

<add>

<doc>

<field name="id">0001</field>

<field name="mmseg4j_complex_name">把Emacs比作是神的编辑器,VIM比作是编辑器之神,

2012年开始接触VIM,一直沿用至今,也曾今总结过VIM的相关知识,

文章都整理在以前的ITeye博客和GitHub,这款古而不老的编辑器至今仍受众多程序员追捧,

当然我也是忠实的VIM用户,这篇文章就是用VIM编辑完成。</field>

</doc>

<doc>

<field name="id">0002</field>

<field name="mmseg4j_complex_name">用Google搜索"Python IDE",

第一条就是stackoverflow上一个非常热门的问题:

"what IDE to use for Python",上百种编辑器的功能对比图让人眼花缭乱。

其中有我接触过的几款编辑器(IDE)包括:Eclilpse(PyDev)、VIM、NotePad++、PyCharm。

如果你的日常开发语言是Python的话,再搜索"python vim",大约有328万条结果,

可见用VIM做Python开发的程序员那是相当之多,我大概总结的几点原因,当然不一定正确</field>

</doc>

</add> |

保存为utf-8格式的文件名:mmseg4j-solr-demo-doc.xml,加入到Solr中去:

E:\solr-4.8.0\example\exampledocs>java -jar post.jar mmseg4j-solr-demo-doc.xml

SimplePostTool version 1.5

Posting files to base url http://localhost:8983/solr/update using content-type application/xml..

POSTing file mmseg4j-solr-demo-doc.xml

1 files indexed.

COMMITting Solr index changes to http://localhost:8983/solr/update..

Time spent: 0:00:01.055 |

看搜索结果:

|