| 编辑推荐: |

本文主要介绍了利用OpenCV建立视差图的整个过程,如何编写此工具的代码。

本文来自于OpenCV学堂,由火龙果软件Anna编辑、推荐。 |

|

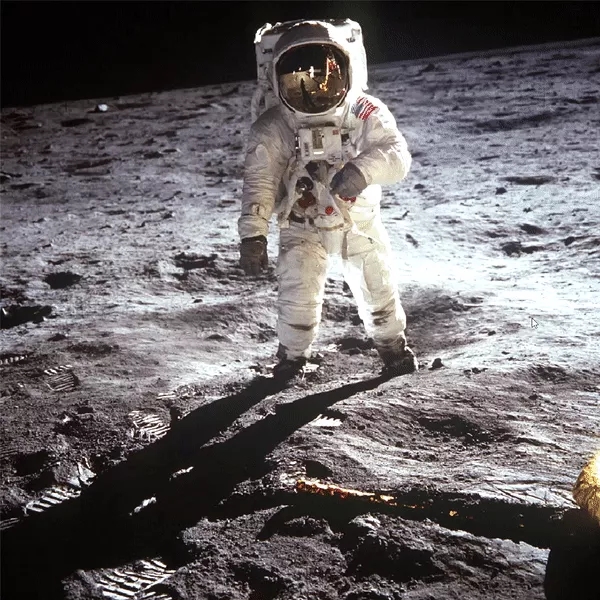

我们都看过3D电影,他们看起来都很酷,这给了我们一个想法,使用一些工具通过改变看图像视角,模拟观众的头部移动。

效果如何?

我们都熟悉"视差"这一术语,它是描述对象在左右眼中的位置差距,视差的大小这取决于我们离它有多远。

视差

因此,如果我们能在2D图像中获得与不同图像层的相同效果,那么我们可以在这些图像中产生类似的感觉,并产生我们想要的酷效果。

让我们分解一下这个过程

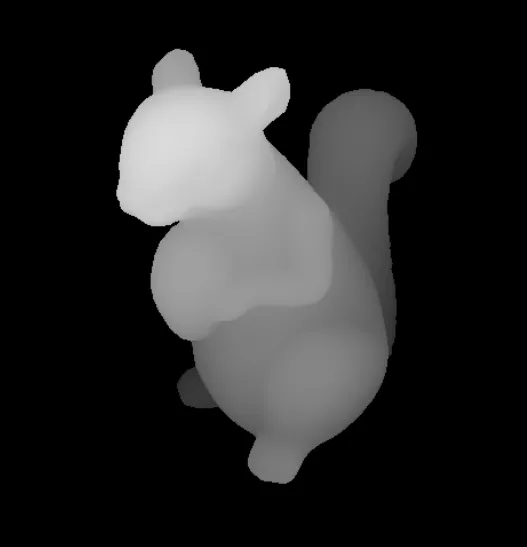

深度图

因此,首先,我们需要将图像分解为不同的图层,并且,我们需要一个2D图像的深度图。深度图只是一个黑白图像,其中图像的白色显示对象与镜头的接近度。获得基本图层后,我们需要从每个图层中画出缺失的部分。最后,我们将单个图像分解成不同的图层。现在,我们可以显示不同的图层,这些图层看起来与原始图像相同。现在,我们可以使用相机进行人脸检测,并测量用户头部的移动,然后移动这些图层并进行匹配。

让我们看看如何编写此工具的代码

因此,首先,我们需要导入一些文件,建议使用版本 4.1.0.25 的

OpenCV。

import os, sys

import numpy as np

import pygame as pg

import cv2 |

现在,我们需要加载图像和深度图,并调整它们的大小以匹配大小。现在,我们将提供一个深度图、代码,但你可以生成自己的模型MiDaS。

img = cv2.imread('moon.jpg',

flags=cv2.CV_8UC4)

depth_map = cv2.imread('moon_depth_map.png')

depth_map = cv2.cvtColor(depth_map,cv2.COLOR_RGB2GRAY)

img = cv2.resize(img, depth_map.shape[:2]) |

现在,在加载深度贴图后,我们可以通过按不同阈值对深度贴图不同图层创建蒙版。在制作一个图层时,我们需要两个蒙版,一个是该图层,另一个是上一层的第二个蒙版,用于画上一个图层的缺失部分。我们将在循环之外取最后一个图层,以便提取此层中的所有剩余部分。

layers = []

prev_thres = 255

div=30

for thres in range(255 - div, 0, -div):

ret, mask = cv2.threshold (depth_map, thres, 255,

cv2.THRESH_BINARY)

ret, prev_mask = cv2.threshold (depth_map, prev_thres,

255, cv2.THRESH_BINARY)

prev_thres = thres

inpaint_img = cv2.inpaint (img, prev_mask, 10,

cv2.INPAINT_NS)

layer = cv2.bitwise_and (inpaint_img, inpaint_img,

mask = mask)

layers.append (conv_cv_alpha(layer, mask))

# adding last layer

mask = np.zeros (depth_map.shape, np.uint8)

mask[:,:] = 255

ret, prev_mask = cv2.threshold (depth_map, prev_thres,

255, cv2.THRESH_BINARY)

inpaint_img = cv2.inpaint (img, prev_mask, 10,

cv2.INPAINT_NS) layer = cv2.bitwise_and(inpaint_img,

inpaint_img, mask = mask)

layers.append (conv_cv_alpha(layer, mask))

layers = layers[::-1] |

我们已经反转了图层,因此我们可以按最后一个层排列到第一层的顺序排列它们。当我们将图层添加到列表中时,我们使用的是函数[conv_cv_alpha],这将添加

alpha 值(使 RGB 到 RGBA),并使用蒙版使图层的某些部分透明。

def conv_cv_alpha(cv_image,

mask):

b, g, r = cv2.split(cv_image)

rgba = [r, g, b, mask]

cv_image = cv2.merge(rgba,4)

return cv_image |

现在来了人脸检测和显示图像的部分。对于人脸检测,我们将使用哈卡卡德。现在,我们将加载

haar 级联进行人脸检测,并创建一个函数,该函数将从图像中返回人脸。

face_cascade = cv2.CascadeClassifier( 'haarcascade_frontalface_default.xml')

def get_face_rect(img):

gray_img = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)

face_rects = face_cascade.detectMultiScale(gray_img,

1.3, 5)

if len(face_rects) == 0:

return ()

return face_rects[0] |

现在,我们必须显示图像,将根据用户的头移动。我们将使用OpenCV读取凸轮,然后使用 Pygame将每个帧呈现在彼此的顶部。为了计算每一层的移位,我们将计算从框架中心的头部移位,然后缩小头移位以获得一个小的移位值。之后,我们将每个图层的索引值相乘,以获得相应图层的移位值,还可以乘以一些常量值,以获得更好的结果。

我们将创建一个比原始图像稍小的 Pygame 窗口并加载相机。我们使用了比例,因此您更改其值以使最终结果变大。

scale = 1

off_set = 20

width, height = layers[0].get_width(), layers[0].get_height()

win = pg.display.set_mode ((int((width - off_set)*scale),

int((height - off_set)*scale)))

pg.display.set_caption ('Parallax_image')

scaled_layers = []

for layer in layers:

scaled_layers.append (pg.transform.scale(layer,

(int(width*scale), int(height*scale))))

cap = cv2.VideoCapture (0, cv2.CAP_DSHOW) |

我们将设置一些常量。你可以玩这些常量来获得不同的结果。

x_transform

= True # allow shift in x-axis

y_transform = False # allow shift in y-axis

sens = 50 # the amount of scale down of shift

value

show_cam = False # show your face cam

shift_x = 0

shift_y = 0

run = True |

最后,主循环渲染所有图层。

while run:

for event in pg.event.get():

if event.type==pg.QUIT:

run = False

ret, frame = cap.read()

frame = cv2.cvtColor (frame, cv2.COLOR_BGR2RGB)

initial_pos = (frame.shape[0]/2, frame.shape[1]/2)

face_rect = get_face_rect(frame)

if len(face_rect) != 0:

x,y,w,h, = face_rect

face_rect_frame = cv2.rectangle(frame, (x, y),

(x + w, y + h), (255,255,0), 3)

shift_x = (initial_pos[0] - (x + w/2))/(sens*scale)

shift_y = (initial_pos[1] - (y + h/2))/(sens*scale)

win.fill((255, 255, 255))

for i, layer in enumerate (scaled_layers):

new_x = -off_set/2

new_y = -off_set/2

if x_transform:

new_x = 0 + shift_x*i

if y_transform:

new_y = 0 + shift_y*i

win.blit (layer, (new_x, new_y))

face_rect_frame = cv2.resize(face_rect_frame,

(100, 100))

if show_cam:

win.blit(conv_cv_pygame (face_rect_frame), (0,

0))

pg.display.update()

cap.release()

cv2.destroyAllWindows()

pg.quit() |

就是这里,最终结果。

最终结果

不同图像的演示

我已经创建了一个更高级版本的这个工具,你可以只选择图像,它会自动创建视差图像,深度地图将自动生成。

|